【论文笔记-5】iTransformer

ITRANSFORMER: INVERTED TRANSFORMERS ARE EFFECTIVE FOR TIME SERIES FORECASTING. Yong Liu, Tengge Hu, Haoran Zhang, Haixu Wu, Shiyu Wang, Lintao Ma, Mingsheng Long. ICLR 2024.

这篇论文是ICLR2024时空数据挖掘论文系列的论文笔记第1篇。

动机

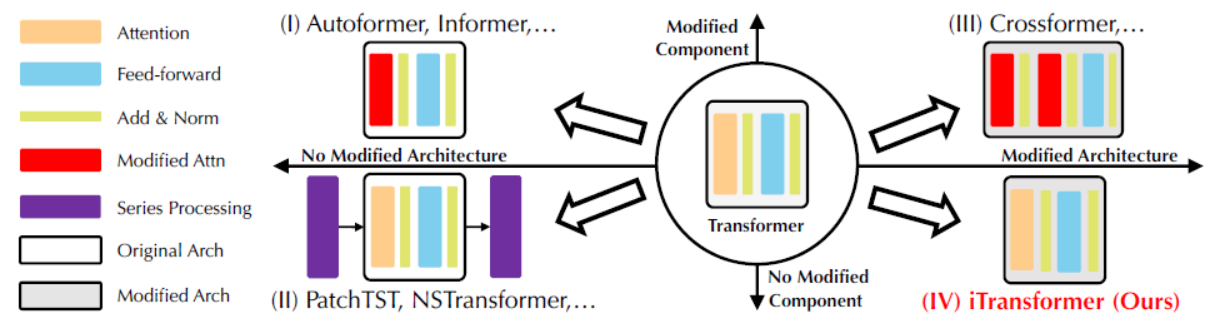

作者认为Transformer用于时间序列预测不够有效,是由于Transformer没有被正确地利用。

任务

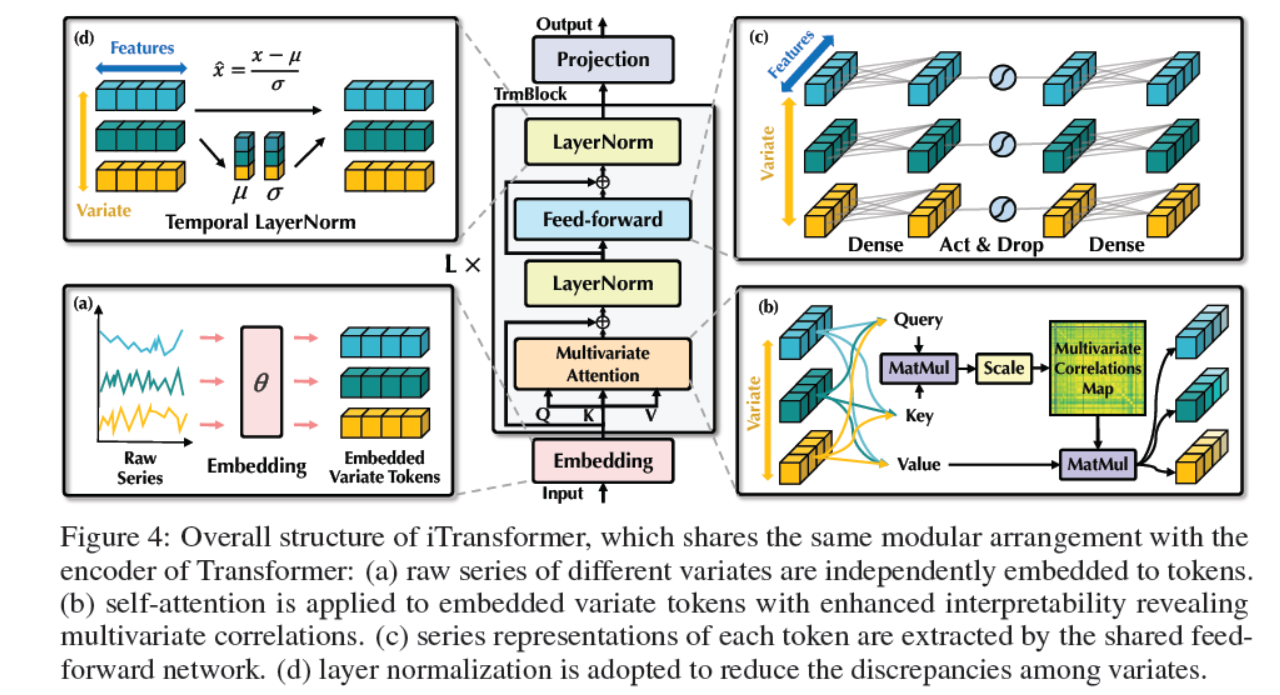

提出了iTransformer框架用于多元时间序列预测,这是一种倒置的Transformer框架,将注意力机制和前馈神经网络倒置。

方法

- 用layer normalization和前馈神经网络来学习每个时间序列的非线性表示。

- 用自注意力机制来学习多变量之间的关系。

评价

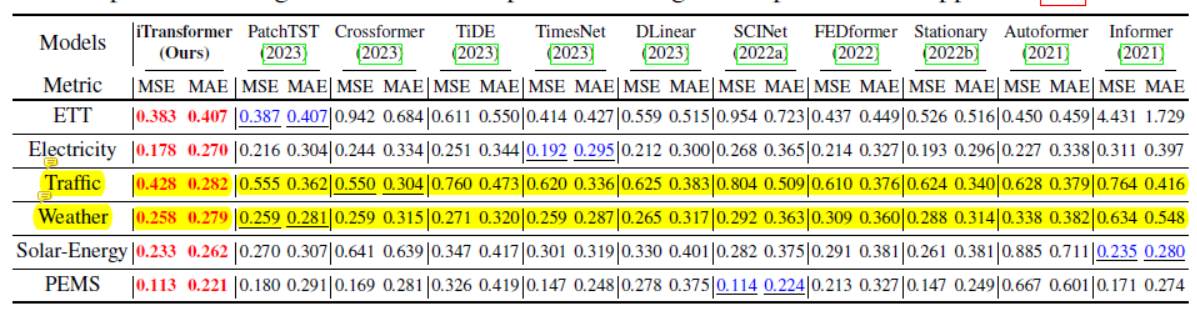

Data

- ETT

- Weather

- Electricity

- Traffic

- Solar-Energy

- PEMS

- Market (6 subsets)

Comparative Methods

- Transformer-based methods

- Informer (Li et al., 2021)

- Autoformer (Wu et al., 2021)

- FEDformer (Zhou et al., 2022)

- Stationary (Liu et al., 2022b)

- Crossformer (Zhang & Yan, 2023)

- PatchTST (Nie et al., 2023)

- Linear-based methods

- DLinear (Zeng et al., 2023)

- TiDE (Das et al., 2023)

- TCN-based methods

- SCINet (Liu et al., 2022a)

- TimesNet (Wu et al., 2023)

- Transformer-based methods

Result

Code

时间序列库TSlib: https://github.com/thuml/Time-Series-Library 这里面包含了iTransformer及相关时间序列预测最新的代码实现

展望

文中提出的iTransformer框架,有望成为时间序列预测的基础骨干框架。

更多

- iTransformer论文解读

https://mp.weixin.qq.com/s/_PKwnt9hjJJyxUiEDZ1EhA - 【论文笔记-1】注意力人流量机器

https://xiepeng21.cn/posts/a7c2a378/ - 【论文笔记-2】深度学习

https://xiepeng21.cn/posts/c0d0024f/ - 【论文笔记-3】用于交通预测的多范围注意力双组分图卷积网络

https://xiepeng21.cn/posts/e8cb7573/ - 【论文笔记-4】Attention Is All You Need

https://xiepeng21.cn/posts/d3e954aa/ - 时空数据挖掘论文库

https://github.com/xiepeng21/research_spatio-temporal-data-mining

【论文笔记-5】iTransformer

https://xiepeng21.cn/posts/4b43950f/